Autorinnen: Maaike Duine (ORCiD) und Maxi Kindling (ORCiD)

Zitierhinweis: Duine, Maaike & Kindling, Maxi (2022) Das Projekt BUA Open Science Dashboards: die Entwicklung disziplinspezifischer Open-Science-Indikatoren. Open Access Blog Berlin. DOI: https://doi.org/10.59350/26ft6-dmv65

Open-Science-Praktiken

Open Access, Open Data, Open Educational Resources, Open Hardware, Open Software, Open Code, Citizen Science: Das Konzept von Open Science umfasst viele Praktiken, die im wissenschaftlichen Alltag zunehmend relevant werden. Sie haben zum Ziel, den wissenschaftlichen Arbeitsprozess, seine Quellen und Ergebnisse langfristig offen zugänglich, nachvollziehbar und nachnutzbar zu machen. Im Berliner Hochschulgesetz wird offene Wissenschaft seit 2021 im §41 adressiert. Dort ist formuliert, dass sie sich auf den „uneingeschränkten und langfristigen Zugang zu wissenschaftlichen Texten, Forschungsdaten, Software und weiteren Forschungsergebnissen und -quellen sowie Lehr- und Bildungsmaterialien“ bezieht, den die Hochschulen ebenso unterstützen sollen wie „einen transparenten Forschungsprozess einschließlich der Bereitstellung von Forschungsinformationen“.

Die Verbreitung von Praktiken offener Wissenschaft ist allerdings im Vergleich von Forschungsinstitutionen, Disziplinen und Wissenschaftler*innen unterschiedlich weit fortgeschritten. Weithin bekannt ist, dass der Anteil an Open-Access-Publikationen in Zeitschriften in den Lebens- und Naturwissenschaften höher ist als in den Sozial- und Geisteswissenschaften [1]. In der Umweltforschung sind Citizen-Science-Praktiken, d.h. die Beteiligung der Öffentlichkeit bzw. von Laien-Wissenschaftler*innen an der Forschung, verbreiteter als in anderen Disziplinen [2]. Weitere Beispiele findet man im Bereich der Veröffentlichung von Preprints, d.h. nicht-begutachteten Vorabveröffentlichungen von Manuskripten im Open Access, die in der Mathematik und anderen naturwissenschaftlichen Fächern gängiger sind (z.B. über die Preprintserver ArXiv oder BioArXiv) [3]. Auch das Teilen von Forschungsdaten (Data Sharing) nimmt zwar in allen Disziplinen stetig zu, aber im disziplinären Vergleich gibt es große Unterschiede. Disziplinen wie die Hochenergiephysik, in denen traditionell viel in (großen) Forschungskollaborationen zusammengearbeitet wird und Data Sharing notwendig ist, werden eher Daten nach den Prinzipien von Offenheit geteilt, als in Disziplinen, in denen das weniger üblich und notwendig ist [4, 5].

Was ist Monitoring und wozu machen wir das? Warum ist das ein wichtiges, aber auch schwieriges Thema?

Mit der Verbreitung offener Wissenschaft steigt auch der Bedarf nach einem Monitoring von Open-Science-Praktiken. Dies erlaubt einen breiten Blick auf die Aktivitäten, kann neue Anreize schaffen, Open Science umzusetzen und setzt Impulse für die Entwicklung von Policies oder Infrastrukturangeboten. Ein Monitoring kann sowohl quantitative wie auch qualitative Darstellungen enthalten. So kann es einerseits darum gehen, den Anteil von offen verfügbar gemachten Publikationen in Bezug auf eine Gesamtzahl von Publikationen zu bestimmen. Aufgrund der unterschiedlichen Publikationskulturen in den Disziplinen ist diese „an Zahlen orientierte“ Herangehensweise aber nicht in allen Forschungsfeldern sinnvoll und adäquat. Eine qualitative Beschreibung von Open-Science-Aktivitäten kann daher ebenso von Bedeutung sein, indem beispielsweise Projekte oder Publikationen deskriptiv und kontextualisierend dargestellt werden, um den Impact in einem bestimmten Forschungsgebiet hervorzuheben.

Ein Monitoring kann sich darüber hinaus auf die Aktivitäten einzelner Wissenschaftler*innen, auf Institutionen, auf Förderprogramme, auf eine nationale oder z.B. auf die europäische Ebene beziehen. Ein Monitoring kann beispielsweise für Förderorganisationen einen Einblick in die Anzahl der Open-Access-Publikationen aus einem bestimmten Förderprogramm geben oder für Institutionen ein Benchmarking (einen Vergleich mit, bzw. eine Orientierung an anderen Institutionen) ermöglichen. Dies zeigt bereits, dass mit dem Monitoring bestimmte Herausforderungen verbunden sind. Dazu gehört die Frage, inwieweit ein Monitoring zum unpassenden Vergleich von Disziplinen führt. Eine weitere Frage ist die nach der Bedeutung etablierter Indikatoren für wissenschaftliche Leistungen im Vergleich zu Open-Science-Indikatoren. Der Journal Impact Factor als Parameter ist hier ein häufig angeführtes und kritisch betrachtetes Beispiel, um die wissenschaftliche Leistung von Individuen und Institutionen zu vergleichen. Initiativen wie die San Francisco Declaration on Research Assessment und Plan S haben zum Ziel, Verfahren zur Leistungsmessung über den Journal Impact Factor und Journal Metrics hinaus zu entwickeln. Die Entwicklung von Indikatoren für offene Wissenschaft (z.B. für die im nächsten Abschnitt erwähnten Monitoring-Ansätze) gehen in die gleiche Richtung, die Forschungsevaluation neu zu denken und beispielsweise Indikatoren wie den offenen Zugang zu Ergebnissen wie Daten und Software, aber auch die Durchführung von offenen Begutachtungsprozessen (Open Peer Review) oder die Zusammenarbeit (Team Science) zu fördern.

Monitoring-Ansätze

Auf europäischer Ebene gibt es verschiedene Initiativen, die das Monitoring von Open-Science-Praktiken voranbringen wollen. Ein Beispiel ist OpenAIRE’s Open Science Observatory, das die Anzahl der Open-Access-Publikationen, Open Data und Open-Access-Journals pro Land anzeigt. Zur Visualisierung der Daten aus verschiedenen Quellen werden Dashboards entwickelt. Im Fall des Open Science Observatory basieren die Daten auf dem OpenAIRE Research Graph, der Daten von institutionellen Repositorien und Zeitschriften mit Daten von Services wie Crossref, Unpaywall, ORCID und Grid.ac verknüpft. Ein anderes Beispiel ist der Open Science Monitor der Europäischen Kommission. Er zeigt in unterschiedlichen Dashboards Trends für Open-Access-Publikationen, Open Data und Open Collaboration. Das Monitoring der Open-Access-Publikationen basiert auf Scopus, Unpaywall und DataCite sowie qualititativen Daten von Umfragen. Darüber hinaus wird angezeigt, wie oft OA-Publikationen auf Social Media und anderen Medien erwähnt werden und die Anzahl der Policies von Forschungsförderorganisationen zu Open Access, Open Data sowie Journal Policies zu Open Data, Open Code und Open Hardware wird angegeben.

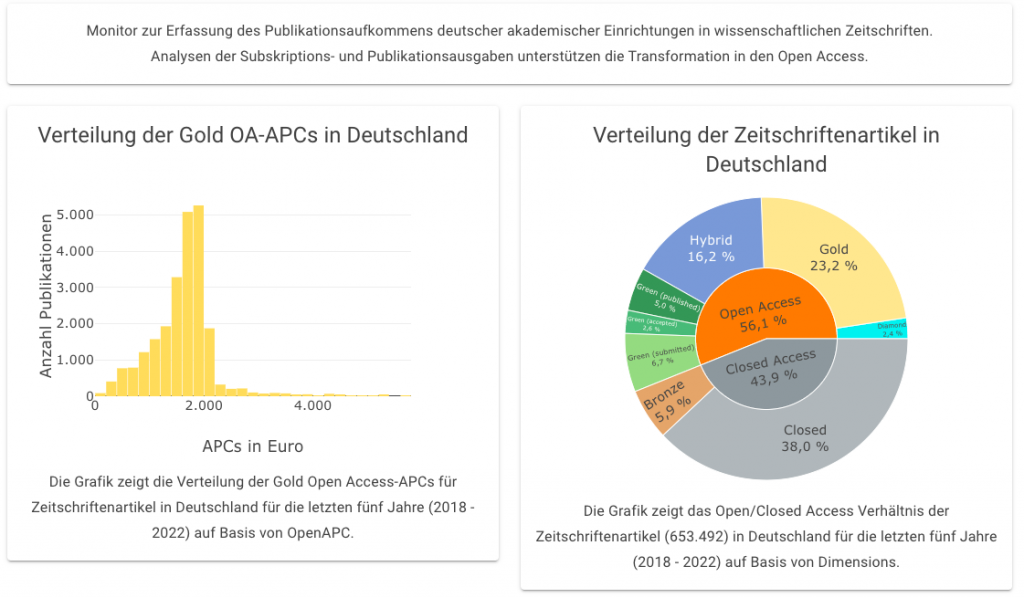

In Deutschland ist der Open Access Monitor ein wichtiges Instrument zur Erfassung des Open-Access-Publikationsaufkommens deutscher akademischer Einrichtungen in wissenschaftlichen Zeitschriften. Der Monitor bereitet die Angabe kategorisiert nach Gold/Green/Hybrid OA und Closed Access auf. Der Open Access Monitor Deutschland basiert ebenfalls auf mehreren Datenquellen. Dazu gehören Dimensions, Web of Science, Scopus, Unpaywall, Directory of Open Access Journals und weitere. Es können aber auch weitere Indikatoren bei nationalen Monitoring-Ansätzen vorgefunden werden: Im niederländischen Open Science Dashboard und dem französischen Open Science Monitor werden z.B. die Zertifizierung von und die Nutzung von persistenten Identifikatoren für Forschungsdaten in Repositorien dargestellt.

Auch auf Landesebene ist das Monitoring relevant: Das OABB koordiniert seit einigen Jahren eine Arbeitsgruppe, die seit 2016 das Open-Access-Publikationsaufkommen in wissenschaftlichen Zeitschriften für die neun publikationsstärksten Berliner Hochschulen erfasst. Dies steht im Zusammenhang mit dem in der Berliner Open-Access-Strategie formulierten Ziel, bis 2020 einen Open-Access-Anteil bei Zeitschriftenartikeln von 60 % zu erreichen. Der zuletzt erschienene Bericht über das Publikationsjahr 2019 wies einen Open-Access-Anteil von 51,6 % nach (der Bericht über das Publikationsjahr 2020 wird derzeit vorbereitet).

Diese Monitoring-Ansätze sind spezialisiert auf das Publizieren in Zeitschriften und zeigen aus verschiedenen Gründen nicht die Diversität der Publikationsformate in den Fachkulturen, die auch Monografien, Sammel- und Konferenzbände, Forschungs-/Kulturdaten, Software, Quellcode, Lehrbücher, Open Educational Resources, Publizieren in Blogs sowie nicht-textuelle Medien, wie z.B. Audio-visuelle Medien und 3D-Modelle umfassen. Ein Problem sind die fehlenden bzw. nicht standardisierten Nachweisquellen, fehlende Indikatorik, Metriken und automatisierte Screening-Tools für diese Formate. Daher sind Monitoring-Ansätze bzw. Dashboards, die auf Disziplinen fokussieren, bislang die Ausnahme.

Das BIH Quest Dashboard

Für die biomedizinische Forschung hat das BIH QUEST Center das Charité Dashboard on Responsible Research erstellt. Die fünf dargestellten OS-Indikatoren Open Access, Open Data, Open Code, Preprints und Anzahl der Forscher*innen mit ORCiD. Datenquellen für OA-Artikel, Preprints und ORCiD sind Unpaywall, Dimensions, und die ORCiD API. Für die OS-Indikatoren Open Data und Open Code wurden die Charité-Publikationen mit einem von QUEST entwickelten Textmining-Algorithmus analysiert: ODDPUB (Open Data Detection in Publications) [6]. ODDPub durchsucht den Volltext der Publikationen nach Aussagen, die auf Daten- oder Code-Sharing hindeuten.

Zuletzt wurde das Charité Dashboard um ein FAIR Dashboard erweitert: Forschungsdaten, die in Publikationen von Charité-Autor*innen aus dem Jahr 2020 erwähnt wurden, werden auf die Umsetzung der FAIR Data Principles geprüft, d.h. ob sie in den Repositorien, in denen sie veröffentlicht wurden, auffindbar, zugänglich, interoperabel und nachnutzbar sind [7]. Dafür wurde das F-UJI Automated FAIR Data Assessment Tool verwendet. Anhand von 16 Metriken wird so die FAIRness eines Forschungsdatenobjekts in einem Repositorium bewertet und kann als Hilfsmittel für Forscher*innen dienen, Services auszuwählen, die Daten möglichst umfassend nachnutzbar bereitstellen.

Entwicklung prototypischer Dashboards im BUA Open Science Dashboards Projekt

Für das Monitoring im biomedizinischen Bereich besteht mit dem Charité Dashboard eine funktionale Lösung, während es für viele weitere Disziplinen keine vergleichbaren Ansätze gibt. Ziel des von der Berlin University Alliance (BUA) geförderten Projekts Open Science Dashboards ist es, mit weiteren ausgewählten Instituten bzw. wissenschaftlichen Communities an den BUA-Einrichtungen zusammenzuarbeiten und gemeinsam Indikatoren für ein prototypisches Dashboard zu entwickeln. Die bestehenden Open-Science-Indikatoren des Charité Dashboards können als Ausgangspunkt für weitere disziplinspezifische Dashboards genutzt werden. Außerdem können neue Indikatoren wie z.B. für Citizen Science, Software, Open Educational Resources oder Open-Access-Bücher entwickelt werden.

Die Dashboard-Prototypen können von Instituts- oder Fakultätsleitungen intern genutzt, von Forscher*innen der Communities selbst verwendet, sowie bei Wunsch auch offen verfügbar gemacht werden. Ein besonderer Schwerpunkt liegt dabei auf der Automatisierbarkeit der Erhebung von Indikatoren sowie der Berücksichtigung der FAIR-Prinzipien.

Wir freuen uns über Fragen und Feedback zu diesem Projekt: oabb@open-access-berlin.de.

Referenzen

- Severin A, Egger M, Eve MP and Hürlimann D. Discipline-specific open access publishing practices and barriers to change: an evidence-based review [version 2; peer review: 2 approved, 1 approved with reservations]. F1000Research 2020, 7:1925. https://doi.org/10.12688/f1000research.17328.2

- Pettibone L, Vohland K, Ziegler D (2017) Understanding the (inter)disciplinary and institutional diversity of citizen science: A survey of current practice in Germany and Austria. PLoS ONE 12(6): e0178778. https://doi.org/10.1371/journal.pone.0178778

- Kristijan Armeni, Loek Brinkman, Rickard Carlsson, Anita Eerland, Rianne Fijten, Robin Fondberg, Vera E Heininga, Stephan Heunis, Wei Qi Koh, Maurits Masselink, Niall Moran, Andrew Ó Baoill, Alexandra Sarafoglou, Antonio Schettino, Hardy Schwamm, Zsuzsika Sjoerds, Marta Teperek, Olmo R van den Akker, Anna van’t Veer, Raul Zurita-Milla, Towards wide-scale adoption of open science practices: The role of open science communities, Science and Public Policy, Volume 48, Issue 5, October 2021, Pages 605–611. https://doi.org/10.1093/scipol/scab039

- Tedersoo, Leho & Küngas, Rainer & Oras, Ester & Köster, Kajar & Eenmaa, Helen & Leijen, Äli & Pedaste, Margus & Raju, Marju & Astapova, Anastasiya & Lukner, Heli & Kogermann, Karin & Sepp, Tuul. (2021). Data sharing practices and data availability upon request differ across scientific disciplines. Scientific Data. 8. 192. https://doi.org/10.1038/s41597-021-00981-0

- Zuiderwijk A, and Spiers H (2019) Sharing and re-using open data: A case study of motivations in astrophysics. International Journal of Information Management: 49, pp: 228-241. https://doi.org/10.1016/j.ijinfomgt.2019.05.024

- Riedel, N., Kip, M. and Bobrov, E., 2020. ODDPub – a Text-Mining Algorithm to Detect Data Sharing in Biomedical Publications. Data Science Journal, 19(1), p.42. http://doi.org/10.5334/dsj-2020-042

- Wilkinson, M., Dumontier, M., Aalbersberg, I. et al. The FAIR Guiding Principles for scientific data management and stewardship. Sci Data 3, 160018 (2016). https://doi.org/10.1038/sdata.2016.18